Здраствуйте все, в этой теме я хотелбы опубликовать все мои статьи, которые были написаны мной, некоторые я уже выклдывал здесь, но они уже давно где-то в середине всех тем, решил собрать в одну тему, чтобы в одном месте находилось пособие по раскрутке сайта...

[spoiler="Моя первая статья: Оптимизация картинок by ser15"]

Оптимизация Картинок

В моей практике было множество сайтов и множество решений в раскрутке.

Хочу поделится очень хорошей информацией и с вами.

Есть такой способ который дает небольшой траф, немного, но приятно.

Рассмотрим подробно:

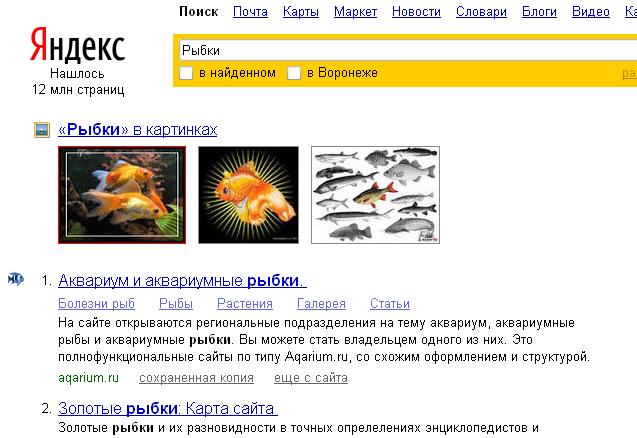

Введем в Яндексе запрос: Рыбки

Как видно на скрине перед основным поиском между сайтами у нас появились горизонтально расположенные 3 большие картинки, которые относятся к категории поиска.

Так и хочется на них кликнуть)

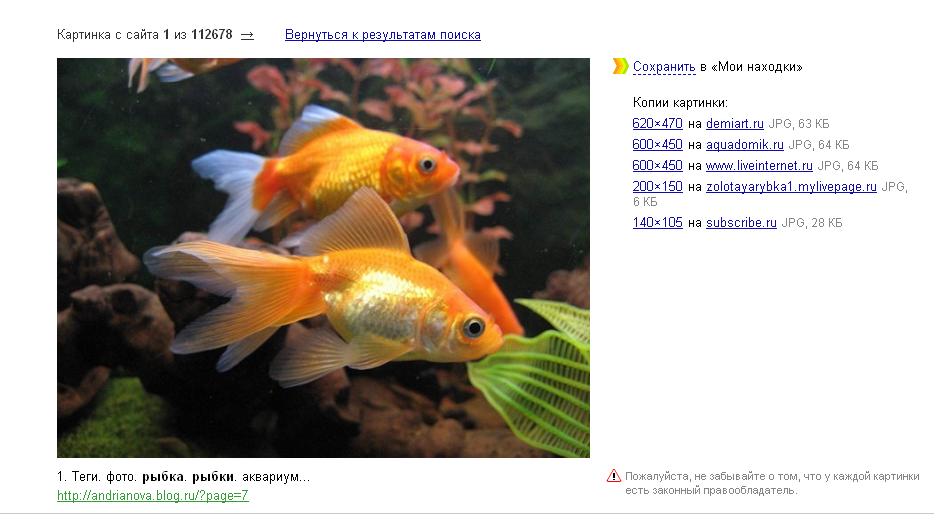

Попробуем нажать на первую картинку.

У нас откроется новая странится где мы увидем:

Внизу картинки есть Топовая ссылка на страницу на котором была расположена и найдена эта картинка.

Это способ раскрутки довольно легки так,как у картинок нет высокой конкуренции и картинки легко вывести в ТОП.

Основным положением в оптимизировании картинки,является тег alt="" именно по нему производится поиск картинок. Соответственно он должен описывать изображенное на картинке. Желательно запихнуть туда ключевик.

Также немалую роль играет тег title="" Он должен быть индентичен тэгу alt.

Картинки также как и контент,должны быть уникальны. если вы создатель или автор картинки желательно пропишите wotemark т.к. он с некой вероятностью защитит картинку от копирования. Если же произойдет копирование, вам будет плюс трафф, реклама вашего сайта на других сайтах)

Также желательно не использовать анимированные картинки и воопще формат gif т.к. велика возможность того, что поисковые системы примут вашу картинку за баннер или часть дизайна сайта.

Текст около картинки должен быть насыщен ключевиками.Это значит, что рядом с картинкой их должно быть больше, чем в остальном тексте.

Имена для файлов лучше давать латинскими буквами. т.к. основной трафф мы хотим получить русский.

Еще одним шагом является размещение pop-up баннеров, так как картинки индексируются хуже чем текст, нам надо улучшить их индексацию и поэтому на страницах желатьельно убрать разнообразные партнерские программы такие как popunder, popuptraf и другие.

Тэги width и height помогут определить размер картинки. Также поисковик попытается узнать объем и палитру картинки. Чем больше информации мы дадим ему, тем сильнее он поднимет картинку в выдаче.

Вот вроди как и все что нужно для оптимизации картинки.

Ну и наконец приведу Пример ак правильно это сделать:

Code

<img width="Ширина(в пикселях)" height="Высота(в пикселях)" border="0" alt="альтернативный текст" title="название" longdesc="Адрес картинки (Желательно полный)" src="Адрес картинки (Желательно полный)" />

[/spoiler]

[spoiler="в индексе google меньше чем за 1 день"]

Итак в этой статье я расскажу как попасть в гугл меньше чем за один день.

для начала идем на страницу центра веб-мастера google ТУТ!

Если у вас уже есть аккаунт заходим в него, если же нет, то регистрируем новый.

После успешного входа в аккаунт у нас откроется окно, где будет кнопочка: +Добавить сайт...

после нажатии на кнопочку вылетет фрейм куда вписываем адрес своего сайта, жмем продолжить... Теперь нам надо подтвердить права на управление этим сайтом. По дефолту это расположение мета-тега.

Итак открываем свой сайт, редактируем метатеги добавляя мету от гугла.

жмем подтвердить... все сайт успешно добавлен. После этого у нас открывается страница где мы можем делать все что угодно с нашим сайтом.

Теперь нам необходимо отправить наш sitemap. После добавления она некоторое время будет индексироватся...

также необходимо правильно составить robots.txt в разделе Доступ для сканера

т.к. в стандартном robots.txt есть строка

Code

User-agent: *

Disallow: /

что запрещает всем роботам просматривать любые страницы сайта.

Так после успешных изменений начнем пересылку в каталоги с большим PR.

Перечислю здесь ссылки на добавление:

http://www.atomenabled.org/everyone/atomenabled/add_url.php?c=5 ПР 7

http://top.bigmir.net/ ПР 6 (для добавления надо регнутся)

http://catalog.tut.by/add.phtml ПР 6 (тут тоже надо зарегестрироватся.

http://library.thinkquest.org/C0111401/add_link.php ПР 6

http://www.a-counter.com/add.html ПР 4

http://ukrmed.org.ua/add.php ПР 3

Вот и все... добавив сайт в эти каталоги и сделав все по инструкции ваш сайт будет проиндексирован в течении 24 часов (могут быть исключения т.к. средний расчет)

Также у этих каталогов, очень даже не паленький тИЦ, что тоже можно использовать для ускорения индексации сайта Яндексом.

[/spoiler]

[spoiler="Статья: составляем правильный robots.txt для uCoz, все о карантине uCoz, индексация сайта"]

Еще раз всем здраствуйте)

В этой статье я расскажу как правильно заточить документ robots.txt под поисковые системы и как быстро попасть в индекс поисковых систем.

Ну начнем:

1. Создание robots.txt под uCoz

Рассмотрим основные теги этого документа:

Disallow: это дистрибутив запрещающий индексацию страницы или каталога.

Allow: это дистрибутив разрешающий индексацию страницы или каталога.

Таким образом мы можем запретить индексацию любого каталога,но разрешить индексацию некоторых страниц тогоже каталога.

Возьмем для примера модуль Каталог файлов

Каталог модуля расположен поадресу /load/

Если поставить:

То каталог файлов у нас индексироватся не будет,но если нам нужны 2-3 странички этого каталога из всех (к примеру всего 10)

То в robots.txt пишем следущие строки:

Code

Allow: /load/адрес страницы

Внимание: строки с разрешением индексации страницы должны быть выше чем строка с запрещением индекса каталога.

Пример:

Code

Allow: /load/адрес страницы

Allow: /load/адрес страницы

Allow: /load/адрес страницы

Disallow: /load/

Таким образом у нас будет индексироватся только те страницы которые указаны под тегом Allow

Теперь разберемся с тегом User-agent

это тег открывающий информацию о боте для которого будут доступны настройки всего того что ниже.

Тег User-agent ставится в самом верху и после него указывается имя бота для проверки

например:

Но если вы хотите указать для каждого бота поисковой системы,либо каталога сайтов и т.п. один и тот же дистрибутив, то ставим следущий тег:

И ниже перечисляем запреты и открытия разных страниц и каталогов.

Итак основная работа сделана и уже можно использовать этот документ для всех ботов, но если вы хотите лучшей индексации сайта и лучшего отоброжения его поисковым системам, лучше вписать еще такие строки:

Code

Sitemap:http://www.имя.домен/sitemap.xml

Sitemap:http://www.имя.домен/sitemap-forum.xml

Это адресация на стандартные карты сайта системы uCoz, если у вас есть свой карта сайта, впишите свою.

Далее тоже не маловажно указать основной домен сайта.

(Если у вас стандартный домен от uCoz то вам ничего делать ненадо)

Если же вы прикрепили какой то домен к сайту, к примеру возьмем net.ru

Он будет отображаться поисковикам как зеркальный домен и будет хуже индексироватся чем основной.

Поэтому многие ошибочно говорят что net.ru и другие подобные домены хуже индексируются чем стандартные от uCoz.

Для того что бы поисковый бот определил прикрепленный домен как основной нам надо прописать в robots.txt такую строчку:

Host: www.имя-сайта.домен

Пример:

Code

Host: www.web-mir.net.ru

Также есть еще много всего,но это особо ненужно и уже по этой инструкции можно составить отличный robots.txt для поисковиков.

Пример готового robots.txt для uCoz:

Code

User-agent: *

Disallow: /a/

Disallow: /stat/

Disallow: /index/1

Disallow: /index/2

Disallow: /index/3

Disallow: /index/5

Disallow: /index/7

Disallow: /index/8

Disallow: /index/9

Disallow: /panel/

Disallow: /admin/

Disallow: /secure/

Disallow: /informer/

Disallow: /mchat

Disallow: /search

Host: www.web-mir.net.ru

Sitemap:http://www.web-mir.net.ru/sitemap.xml

Sitemap:http://www.web-mir.net.ru/sitemap-forum.xml

Так с robots.txt разобрались.

2.Теперь разберемся со скоростью индексации сайта созданного в системе uCoz. На uCoz есть такая штука под название Карантин

Подробнее о нем можно узнать тут: http://forum.ucoz.ru/forum/21-13447-1

Ну а теперь и я расскажу все что знаю про этот карантин:

После создания каждого сайта у него есть некоторые ограничения, одним из них является закрипление стандартного robots.txt

и его к сожалению никак нельзя отредактировать... если залить свой в корень сайта, тоже останется стандартный.

Казалось бы ну и что в том, что он стандартный?

Да ничего хорошего, в нем прописана такая строка:

Code

User-agent: *

Disallow: /

Эта строка запрещает всем поисковым системам индексировать ваш сайт.

Итак как же снять карантин?

есть 3 способа

1) По каким то не умным действиям администрация uCoz снимает карантин если сайт хорошо посещается. Но они не подумали как он будет хорошо посещатся если он закрыт для индекса.

2) Подождать отведенное время карантину (1-2 месяца)

3) Приобрести Премиум аккаунт (любой).

Вот в админке видем такой тариф:

Базовый ($3.09)

Если его приобрести, у нас автоматически снимается карантин и мы можем спокойно заявить поисковикам о нашем сайте.

Спасибо за внимание

Автор: ser15

Источник: http://web-mir.net.ru/

[/spoiler] [spoiler="Угроза в Яндексе, как боротся и как не попасть"]

Здраствуйте. В этой статье я расскажу подробно об фильтрации сайтов поисковой системы Яндекс

Итак для начала что же это такое?

Сразу меньше слов, больше дела, это вот такая надпись убирающая описание поиска и написано вместо этого, что сайт может угрожать безопасности компьютера. Вот примерно так:

Итак начнем.

В этой статье рассмотрим самою высокочастотную ошибку веб-мастеров из-за которой бывает угроза.

Это реклама всплывающих баннеров, различных кликунов и т.п.... ПС определяет это как вирус и пишет что сайт может угрожать безопасности вашего компьютера.

Теперь рассмотрим вопрос:

Как же мне размещать рекламу и не угробить свой сайт?

Ответ прост:

1) Для начала откроем любой текстовый редактор (пойдет тот же блокнот)

2) Скопируем код партнерки

3) жмем сохранить как (кодировка: utf-8) название.html

Это будет страница с партнеркой.

Загружаем страницу в корень сайта и сразу же прописываем в robots.txt запрет на индексацию этой страниы:

Code

Disallow: /название.html

Итак основа всего сделана, осталось только открыть шаблон и прописать между и

этот код:

Code

<iframe src="адрес/название.html" width="100%" height="100%"></iframe>

Таким образом Поисковый бот никогда не подумает что на вашем сайте есть какие либо угрозы в виде рекламы, и будет видеть лишь переадресацию на страницу сайта, на которую ему запрещено переходить.

Теперь вы можете размещать рекламу на своих сайтах и зарабатывать, не переживая за свой сайт.

Удачи!

Автор: ser15

Сайт автора: http://web-mir.net.ru/

Источник: http://web-mir.net.ru/

[/spoiler] [spoiler="Способ вывода сайта из под фильтров поисковых систем"]

Итак снова здраствуйте дорогие пользователи портала web-mir.net.ru

На собственных ошибках и приемах исследовал фильтры поисковых систем и решил написать статью о попадении сайта под фильтры и вывода из них.

В статье подробно описано из-за чего попадает сайт под фильтры и различные способы гарантированно выводящие сайт из филтров поисковых систем.

Итак начнем!

Для начала разберем некоторые факторы которые просто уговаривают поисковые системы запихнуть сайт под фильтр.

Это может быть:

1)Всплывающие баннеры popunder и другие. (их лучше кодировать)

2)Контент состоящий только из Copy-past (Полное копирование материалов с других сайтов.

3)Поисковый спам (Мета теги отражающие информацию, которую сайт не влечет за собой)

Также к поисковому спаму относится большое кол-во ключевых слов на странице (если использовать ключевик после каждого слова, поисковый фильтр ваш!)

4)Частое использование тегов h1 в ненужных местах и воопще на странице сайта.

Также есть еще множество факторов влияющих на отношение сайта с поисковыми системами, но это самые основные.

Вроде нам теперь понятно чего стоит остерегаться, но все же если сайт попал под фильтр, раскрываю некоторые способы которые помогают вывести сайт из под этих ужасных фильтров.

I.

1)Для начала проверяем сайт на копи-паст и на наличие тегов META и h1, их лучше переделать в облегченный вариант не более 50 символов в ключевых фразах и описании сайта, а также лучше убрать на время теги h1

2)Если вы не находите проблему, попробуйте поспрашивать знающих людей на разных форумах, к примеру: maulnet или seo-cafe

Если там неполучили информацию, то пишем ПЛАТОНУ (если фильтр от Яндекс) или же (если фильтр от другой поисковой системы) в тех поддержку ПС.

Вероятно если ненашли причину, ваш сайт выведут из под фильтров.

3)Если же все таки проблема была найдена, устраните ее и напишите 5-10 уникальных статей

P.S. все статьи должны быть на главной странице сайта и с уникальностью не ниже 80%

4)После чего также пишем в тех. поддержку ПС и ждем вывода, или ответа о том что нужно еще изменить.

II.

Если вам дорог ваш копи-паст или же поисковая оптимизация со спамом ключевиков (что хорошо для посещения т.к. более высокое место в запросе)

1)Делаем резервную копию нашего проекта.

2)Идем на сайт крупной компании (любой)

3)В браузере во вкладке файл жмем сохранить как, таким образом мы сохраним страницу.

P.S. сохраните 5-10 страничек

4)Пишем тех. поддержке поисковой системы примерно таким текстом:

"Как так вы не индексируете наш сайт, мы большая компания пользуящаяся спросом, которая имеет авторитет в данной тематике"

5)Ждем пока сайт ачнет индексироватся и разворачиваем нашу резервную копию

Но это не дает гарантий на повторный фильтр от ПС и во второй раз будет тяжелее уже.

[/spoiler]

[spoiler="Статья: Что такое поисковые запросы и как их продвигать?"]

Здраствуйте.

Пока есть время решил написать еще одну статью, которая поможет вам узнать что такое низкочастотные (НЧ), среднечастотные (СЧ) и высокочастотные (ВЧ) запросы.

Также расскажу как осуществляется продвижение по тем или иным запросом.

Итак давайте разберем какие бывают запросы.

1)Низкочастотные-запросы определенный тематики (углубленно) к примеру Скачать Программу верссии 3 это низкочастотный запрос

2)Среднечастотные- запросы определенной тематики также, но уже не определенно чего, к примеру:

Скачать Базы Allsubmitter

т.е. не описано какую именно базу и какой она должна быть, т.е. разные базы Allsubmiiter

3)Высокочастотные - запросы обьединяющие несколько тематик, к примеру

скачать шаблоны

Т.е. по данному запросу поисковик выдаст сайты, на которых можно скачать шаблоны и для сайтов, и для Photoshop и для всего чего только можно придумать...

Теперь немного о продвижении по разным запросам:

Естественно легче всего продвигать Низкочастотные запросы, т.к. у таких запросов конкуренция меньше всего и с меньшей конкуренцией легче продвинуть свой запрос в ТОП выдачи

Теперь расскажу о разнице:

Естественно, если продвигать высокочастотный запрос, то и трафика будет больше, но по таким запросам лучше даже не пытатся самому продвигать, т.к. на данный момент в интернете достаточно много компаний занимающихся продвижение сайтов именно по высокочастотным запросам. Согласитесь одному человеку гораздо тяжелее продвигать сайт, чем компании занимающийся этим уже длительное время и вычеслившим уже многие алгоритмы поиска разных поисковых систем.

Но не мне вас заставлять не продвигать ВЧ запросы, это решать уже вам и только вам, а мне осталось рассказать, как продвигать эти апросы.

Конкертно о каком-либо запросе я рассказывать не буду, расскажу о том как осуществляется продвижение всех запросов.

Самый основной и неотьемлимый этап - это оптимизация сайта, под те или иные запросы.

Об этом я рассказывать не буду, т.к. сам в этом не очень хорошо соображаю.

Лучше поищите в интернете пособие по оптимизации сайта под разные поисковые запросы.

Теперь расскажу о втором немаловажном факторе продвижения запросов.

Этим фактором являются анкоры ссылок.

Давайте поподробнее рассмотрим, чтоже такое анкор.

Анкор это - это скрытая ссылка под каким-либо запросом или ключевой фразе.

к примеру все для веб-мастера.

Что мы видем:

1)Собственно сам запрос "все для веб-мастера"

2)Ссылку на сайт web-mir.net.ru

Это и есть Анкор

Таким образом если вы пишете статью и размещаете ее в различных каталогах статей, на различных сайтах старайтесь указывать источник анкором.

Допустим вы написали статью на тематику: "Создание сайтов"

и в конце этой статье укажите источник таким образом:

Code

Источник:<a alt="Создание сайтов" title="Создание сайтов" href="Ссылка на ваш сайт">Создание сайтов</a>

Таким образом разместив вашу статью в различных каталогах статей на различных сайтах и дождавшись пока поисковая система проиндексирует ваши статьи вы обеспечите отличное продвижение запроса Создание сайтов.

Вот и все.

Помните есть другие способы установки анкоров, такие как посты на различных форумах, можете установить свою подпись с анкором и ссылкой на ваш сайт, если это не запрещено форумом.

Включайте мозги и думайте как продвигать запросы.

Автор статьи: ser15

Источник: http://web-mir.net.ru/

[/spoiler]

Вот такой пока небольшой, но уверен, хоть чем-то полезный сборник статей

Удачи!